Al analizar una grabación de audio, los investigadores lograron animar una cara pero también y sobre todo aplicar las emociones desde la grabación de audio. Un hallazgo que podría mejorar los gráficos en los juegos pero también, por desgracia, producir videos de tipo "deepfake" cada vez más realistas.

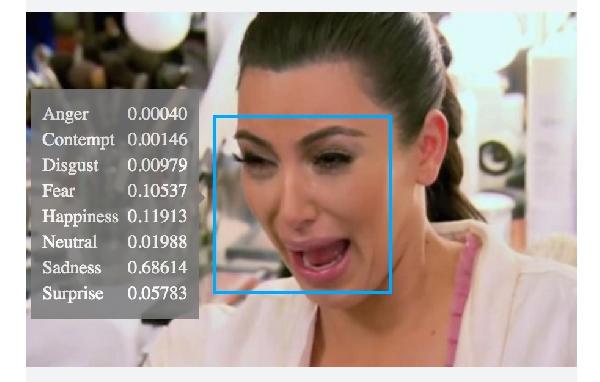

Un equipo de investigadores de Microsoft acaba de publicar un artículo en el que describen un nuevo sistema desarrollado para animar rostros basado únicamente en una grabación de audio. Este nuevo método aprovecha los avances en el campo del aprendizaje profundo para crear un video de una cara que habla traduciendo las emociones detectadas en la voz.

La animación facial basada en una grabación no es completamente nueva, pero los métodos actuales suponen que la muestra de sonido sea clara, sin ruido de fondo y un tono neutro. El nuevo sistema utiliza un codificador automático variacional (VAE) que aprende a desentrañar los diversos componentes de la grabación de audio, incluida la parte fonética, el tono emocional y el ruido de fondo. Esto le permite ser mucho más robusto y poder crear animaciones a partir de grabaciones más naturales.

Muchas aplicaciones en doblaje y animación 3D

La pista de audio se divide en representaciones que luego se pueden usar con diferentes métodos de animación. Sin embargo, los investigadores de Microsoft han utilizado redes de antagonistas generativos (GAN), dos redes neuronales en competencia para crear sus videos. Esto les permite no solo animar una cara que "habla", sino también infundir las emociones transcritas desde la grabación de audio.

Al igual que cualquier tecnología, se podría abusar para crear falsificaciones muy precisas. Sin embargo, los autores se centran en aplicaciones más útiles, como copiar un video en otro idioma, avatares 3D generados en tiempo real o mejorar las animaciones de los personajes en los videojuegos.

Facebook crea una IA capaz de copiar la voz de cualquier persona